Une vague de suppression d’index frappe le web depuis la fin mai 2025, et franchement ça fait mal.

Des milliers de sites voient leurs contenus disparaître des résultats de recherche du jour au lendemain.

Cette situation préoccupe toute la communauté SEO mondiale, mais les explications de Google apportent quelques éléments de réponse même si on reste sur notre faim.

Sommaire

- Pourquoi Google procède-t-il à cette désindexation en masse ?

- Quels types de contenus sont visés par cette désindexation ?

- Quel impact cette désindexation a-t-elle sur les sites concernés ?

- Quelles actions peut-on prendre pour limiter le risque de désindexation ?

- Que signifie cette désindexation pour l’avenir du SEO ?

Pourquoi Google procède-t-il à cette désindexation en masse ?

Google a lancé cette désindexation massive depuis fin mai pour nettoyer son index et montrer aux internautes uniquement ce qui a réellement de la valeur. Le but n’est pas juste de supprimer des pages anciennes; mais de retirer toutes celles qui n’apportent rien de nouveau ou qui recopient ce qui existe déjà.

Ce n’est pas un hasard si des sites qui utilisent des astuces pour manipuler leur position disparaissent aussi. Cette opération touche aussi bien les petits blogs que les grandes plateformes partout dans le monde. Comprendre pourquoi Google agit ainsi est essentiel pour adapter sa stratégie et éviter de se faire éjecter.

Voici ce que Google cherche à faire avec cette purge :

- Supprimer les pages sans contenu original ou intéressant.

- Réduire les doublons et les contenus copiés

- Éliminer les pages dépassées qui n’ont plus d’utilité réelle.

- Sanctionner les méthodes SEO qui trichent avec les règles.

- Améliorer la qualité des résultats affichés aux utilisateurs

- Garder un index clair malgré la masse de contenu en ligne.

Quels types de contenus sont visés par cette désindexation ?

Google supprime ces pages parce qu’elles n’apportent pas de valeur réelle aux visiteurs. Elles sont souvent trop brèves ou superficielles pour répondre aux questions que se posent les internautes.

Ces contenus légers ne retiennent pas l’attention et génèrent un fort taux de rebond ; le moteur privilégie les pages qui offrent des informations solides et utiles pour améliorer l’expérience utilisateur.

Contenus dupliqués

Google sanctionne la répétition de contenu identique sur plusieurs pages ou sites. Ces doublons brouillent la clarté des résultats et compliquent le travail du moteur pour déterminer quelle page afficher en priorité. Les utilisateurs se retrouvent face à des résultats répétitifs qui ne répondent pas à leurs attentes, cela nuit à la crédibilité des sites qui reproduisent ces contenus.

Raisons pour cibler les contenus dupliqués

- Résultats moins variés pour les utilisateurs

- Difficulté à identifier la source originale du contenu

- Perte d’autorité pour les sites concernés

- Expérience utilisateur dégradée par la répétition

Pages générées automatiquement sans supervision humaine

Les pages produites automatiquement sans contrôle humain manquent souvent de cohérence et contiennent des erreurs, elles ne répondent pas aux besoins réels des visiteurs.

Google favorise les contenus validés par des humains, garantissant ainsi une certaine qualité. Les pages générées automatiquement sont perçues comme peu fiables et sans valeur ajoutée.

Raisons pour cibler ces pages

- Absence de relecture humaine

- Forte probabilité d’erreurs et d’incohérences

- Faible intérêt pour les visiteurs

- Risque de spam ou de contenu hors sujet

Contenus obsolètes non mis à jour

Les pages non actualisées depuis longtemps perdent leur pertinence. Elles peuvent contenir des informations dépassées qui ne correspondent plus aux attentes des utilisateurs. Google privilégie les contenus frais et fiables afin d’assurer la meilleure expérience possible.

Raisons pour cibler ces contenus

- Informations périmées ou inexactes

- Pertinence diminuée face aux contenus récents.

- Risque de désinformation

- Mauvaise expérience utilisateur liée à l’ancienneté

Sites abusant des pratiques SEO manipulatrices

Google sanctionne les sites qui utilisent des techniques visant à manipuler les résultats de recherche. Ces pratiques faussent la concurrence et pénalisent les sites respectant les règles. L’objectif est de garantir une compétition équitable et d’améliorer la qualité des résultats pour les internautes.

Raisons pour cibler ces sites

- Classements obtenus par des méthodes interdites

- Non-respect des consignes Google

- Injustice envers les sites honnêtes

- Baisse générale de la qualité des résultats

Pages avec problèmes techniques empêchant une bonne indexation

Pour être bien indexée, une page doit être accessible et correctement structurée. Les erreurs techniques peuvent empêcher les robots d’indexer vos pages. Par exemple, un temps de chargement trop longs ou une mauvaise organisation empêchent l’exploration de vos contenus.

Raisons pour cibler ces pages

- Erreurs serveur fréquentes 404 ou 500

- Structure confuse ou mal pensée du site

- Temps de chargement excessif

- Difficultés d’accès pour les robots d’exploration

Quel impact cette désindexation a-t-elle sur les sites concernés ?

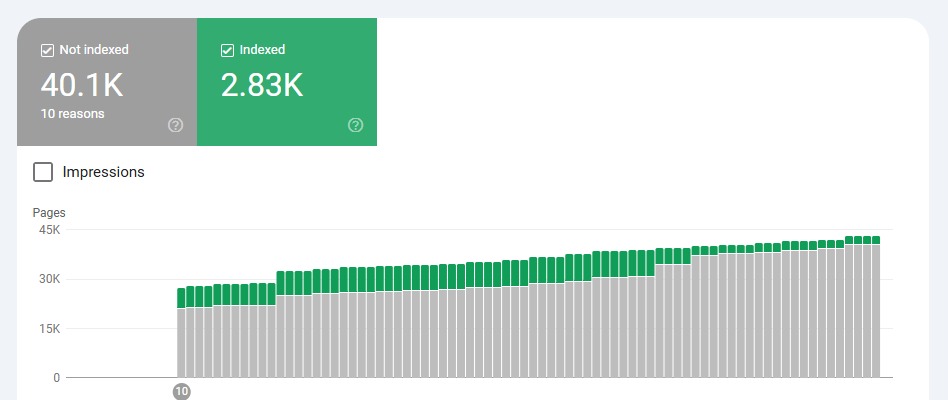

Beaucoup de sites ont vu leurs pages disparaître du jour au lendemain sans aucun avertissement. C’est souvent en consultant la Search Console ou en constatant une chute brutale du trafic que les éditeurs réalisent ce qui se passe.

les positions qui tenaient depuis des années ne sont plus là, et aucune alerte de Google, juste un silence froid et un trou dans les statistiques.

Conséquences directes sur le trafic

Les effets ne sont pas progressifs, ils tombent d’un coup. Ce n’est pas une simple variation comme lors d’une mise à jour classique.

Voici ce que beaucoup ont constaté :

- Chute de 30 à 70 % du trafic organique en moins d’une semaine

- Pages auparavant bien classées devenues invisibles sur Google

- Sessions divisées par deux,, voire plus,, sur certains articles piliers..

- Mots-clés principaux qui ne déclenchent plus aucun affichage.

Tensions et perte de confiance

Dans les forums SEO ou les groupes professionnels, la tension est palpable : : certains parlent d’un nettoyage juste. D’autres dénoncent une purge injustifiée. Une chose est sûre : cette désindexation massive ébranle la relation de confiance entre Google et les éditeurs de contenus.

Effets collatéraux observés

- Gel ou report de publication en attente de comprendre

- Refonte éditoriale précipitée sans stratégie claire

- Inquiétude sur la pérennité de certains business modèles

- Abandon temporaire de la production de contenu

- Questionnement sur la dépendance totale à Google

Quelles actions peut-on prendre pour limiter le risque de désindexation ?

La première étape, c’est de regarder son site avec un œil froid ; supprimer ce qui n’apporte rien, mettre à jour ce qui peut encore servir et fusionner les pages qui se répètent ou qui se cannibalisent.

C’est un travail long et souvent désagréable, mais c’est aussi ce qui fait la différence entre un site nettoyé et un site oublié par Google.

Renforcer la qualité avant la quantité

Publier plus ne sert à rien si chaque nouveau contenu n’apporte pas une vraie valeur. Il faut se poser la question simple : est-ce que j’aurais publié ça si Google n’existait pas. Si la réponse est non; il vaut mieux s’abstenir; l’objectif est de devenir réellement utile, pas juste de remplir des cases SEO.

Bonnes pratiques pour produire du contenu utile

- Apporter des réponses précises à des vrais besoins

- Ajouter son expertise personnelle et son expérience

- Éviter les généralités types 5 conseils pour mieux dormir

- Créer moins souvent mais avec plus de profondeur.

Reprendre le contrôle sur le contenu généré par IA

L’intelligence artificielle n’est pas interdite, mais elle ne doit pas publier seule. Un contenu généré automatiquement sans intervention humaine est aujourd’hui l’une des cibles principales de Google. Chaque texte produit avec un outil doit être vérifié, retravaillé, enrichi; sinon il risque d’être écarté sans discussion.

Conseils pour bien encadrer l’usage de l’IA

- Toujours relire et éditer manuellement chaque contenu IA

- Ajouter des exemples concrets ou des données uniques

- Éviter les formats trop mécaniques et trop propres

- Mélanger écriture humaine et automatisation avec intelligence

Surveiller les signaux techniques

Un site lent, mal structuré ou rempli d’erreurs peut voir son indexabilité chuter. En effet, Google ne peut pas indexer ce qu’il n’arrive pas à explorer correctement. Il faut donc revoir régulièrement l’état technique de son site pour s’assurer qu’il reste lisible, rapide et propre.

Éléments techniques à vérifier régulièrement

- Temps de chargement des pages

- Codes d’erreur 404 ou 500 trop fréquents

- Problèmes d’indexation signalés dans Search Console

- Présence d’un sitemap à jour et bien structuré.

Se détacher un peu de Google

Ce n’est pas facile, mais c’est nécessaire ; un site qui repose à 100 % sur Google vit dans la peur permanente de l’algorithme. Il faut diversifier son trafic en développant une newsletter; une communauté ou d’autres canaux qui garantissent un minimum d’indépendance.

Canaux à développer pour gagner en autonomie

- Newsletter régulière avec du contenu exclusif

- Présence active sur un réseau social adapté à sa thématique

- Référencement local ou vertical en dehors de Google

- Partenariats croisés avec d’autres sites de confiance

Que signifie cette désindexation pour l’avenir du SEO ?

Ce que beaucoup prennent pour une crise est peut-être un vrai changement de cap. Google ne veut plus d’un web gonflé aux mots-clés ; ni de contenus juste faits pour l’algorithme.

Ce qu’il semble viser maintenant, c’est une version plus épurée du web ; une sorte de nettoyage par le vide qui oblige les sites à faire mieux ou à disparaître.

La fin du contenu moyen

Avant, on pouvait encore survivre avec du contenu banal si on optimisait bien les balises et les titres. Ce temps semble révolu ; l’ère du contenu moyen pour remplir une page est clairement en train de mourir. Ceux qui veulent rester visibles vont devoir écrire plus juste, plus utile et surtout plus humain.

Tendances qui se dessinent

- L’expertise réelle devient une exigence, pas un bonus

- La fraîcheur et la mise à jour comptent plus que jamais

- Les signaux d’engagement prennent le dessus sur les backlinks

- Les contenus automatisés non supervisés sont désormais à haut risque

Un SEO plus proche du contenu que de la technique

Ce virage remet au centre ce que beaucoup avaient mis de côté : le fond. Ce n’est plus seulement une affaire de vitesse ou de structure, c’est une affaire de pertinence.

Ceux qui comprennent les attentes de leurs visiteurs auront toujours une longueur d’avance; même si les règles changent, les vrais besoins restent.

Moins de place pour les sites anonymes

Google semble aussi pousser vers plus d’autorité et de traçabilité; les contenus sans auteur identifié ou sans crédibilité perçue reculent. Ce n’est plus un jeu ouvert où tout le monde peut créer et espérer ranker; c’est un filtre qui se durcit.

Signes de cette évolution

- Priorité aux sites à forte légitimité thématique

- Montée de l’importance de l’EEAT: expérience, expertise, autorité, fiabilité

- Valorisation des marques personnelles ou d’auteurs connus

- Déclassement des sites sans visage ni voix identifiable

Vers une dépendance plus risquée

Ce qui frappe dans cette vague de désindexation; c’est à quel point certains sites sont dépendants de Google à 100 %.

Une simple mise à jour suffit à couper le trafic du jour au lendemain; sans stratégie alternative, pas de plan B; et ça pousse toute une industrie à repenser son modèle.

Réflexions à avoir pour la suite

- Comment diversifier ses sources de trafic durablement

- Faut-il publier moins, mais mieux

- Quel contenu suis-je prêt à défendre sans Google

- Mon site survivrait-il à une désindexation totale

Un nouveau cap pour le référencement

Cette vague de désindexation marque un vrai tournant dans le monde du SEO; fini le temps du contenu superficiel et des astuces faciles. La priorité est désormais à la qualité, à l’expertise et à la valeur réelle apportée aux internautes.

Pour durer; il faut s’adapter rapidement et repenser sa stratégie en profondeur; anticiper ce changement devient indispensable pour rester visible demain.